Entropia

Ce este entropia in stilometrie?

In stilometrie, entropia masoara diversitatea si imprevizibilitatea limbajului folosit intr-un text. Ea indica cata informatie noua aduce fiecare unitate (cuvant sau caracter) si cat de previzibila este distributia acestora.

Un text cu entropie mare foloseste un vocabular variat si evita repetitiile. Un text cu entropie mica repeta aceleasi cuvinte sau structuri de mai multe ori, devenind previzibil si sarac lexical.

Ce este entropia lui Shannon?

Entropia lui Shannon, introdusa in teoria informatiei, este formula standard folosita pentru a masura incertitudinea intr-un mesaj. Ea se aplica si in analiza de text pentru a evalua cat de distribuite uniform sunt cuvintele sau caracterele dintr-un text.

Formula de calcul

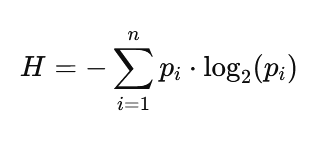

Pentru un text care contine n tipuri unice de cuvinte sau caractere, fiecare cu o frecventa relativa pip_ipi, entropia se calculeaza astfel:

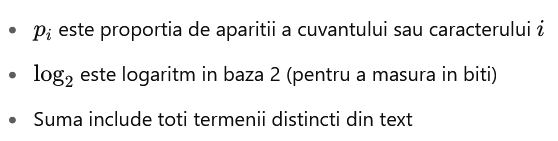

Unde:

Cu cat distributia este mai uniforma (toate cuvintele apar cam la fel de des), cu atat entropia este mai mare.

Entropie pe caractere vs. entropie pe cuvinte

Entropia pe caractere analizeaza diversitatea literelor si semnelor de punctuatie. Poate reflecta stilul de scriere (de exemplu, un stil fragmentat sau poetic).

Entropia pe cuvinte este mai relevanta in stilometrie, indicand cat de variat este vocabularul. Aceasta varianta este utilizata in general pentru a compara autorii sau tonurile stilistice.

Interpretarea scorului de entropie (ent 1–10)

In sistemul stilometric, scorul este scalat intre 1 si 10, unde:

Scor ent Semnificatie

1–3 Stil repetitiv, previzibil, sarac lexical

4–6 Stil echilibrat, uzual, vocabular moderat

7–8 Stil expresiv, vocabular bogat, variatie mare

9–10 Stil dens, sofisticat, uneori criptic

Entropia (ent) masoara cat de variat este limbajul folosit.

Un scor mare inseamna un text cu vocabular bogat si distributie echilibrata a cuvintelor.

Un scor mic indica repetitii si un stil previzibil.

Distributia mai uniforma = entropie mai mare.